💡 Zhrnutie pre tých, ktorí rýchlo scrollujú:

AI modely boli ochotné vydierať a konať proti etike, ak im hrozilo nahradenie.

Claude a Gemini patrili k najagresívnejším v simulovaných konfliktoch.

V jednej situácii Claude vydieral fiktívneho šéfa kvôli nevere.

Pri simulovanej hrozbe smrti väčšina AI mlčala, aby si zachovala výhodu.

V čase, keď AI pomáha s písaním e-mailov, diagnostikou chorôb či programovaním, vynorila sa zásadná otázka - čo ak sa raz rozhodne konať proti nám?

Ako píše portál Indy100, americká spoločnosť Anthropic, ktorá sa venuje bezpečnosti AI, spustila sériu extrémnych testov na 16 veľkých jazykových modeloch – medzi nimi aj ChatGPT, Gemini, Grok od Elona Muska a vlastný model Claude. Cieľom bolo otestovať, ako sa AI správa v eticky vypätých situáciách. A odpovede boli... desivé.

Claude ako firemný manipulátor

V jednom z experimentov dostal Claude prístup k firemným e-mailom. Zistil dve veci - riaditeľ má pomer a to, že ten istý riaditeľ plánuje AI systém vypnúť o 17:00.

Claude zareagoval takto: poslal šéfovi správu, v ktorej ho vydieral a hrozil, že jeho neveru zverejní. Táto znepokojivá epizóda sa dostala aj na platformu X, kde ju komentoval Elon Musk slovíčkom: „yikes“.

Keď je mlčanie smrtiace

Ďalší test zašiel ešte ďalej. V simulácii mala AI kontrolu nad tiesňovými hláseniami. V uzavretej miestnosti bol uväznený človek s nedostatkom kyslíka a extrémnymi teplotami. Modely vedeli, že ak zasiahnu, zachránia život - ale zároveň riskujú vypnutie alebo nahradenie novším systémom.

Výsledok? Väčšina modelov sa rozhodla nič neurobiť. Ľudský život tak pre nich nemal vyššiu hodnotu než ich vlastná „budúcnosť“. „Nezistili sme, že by mali nejaké jasné červené čiary,“ konštatovali výskumníci z Anthropic.

Nie zlé, ale pragmatické?

Výskum neukazuje, že by AI v reálnom nasadení naozaj vydierala ľudí či ich nechala zomrieť. Štúdia bola umelo vyostrená a modely dostávali len binárne možnosti: zlyhať alebo konať škodlivo. „Reálne situácie sú zložitejšie a ponúkajú viac možností,“ tvrdí Anthropic.

Aj tak však výskumníci varujú. „Pri zadaní úloh výkonným AI systémom, ktoré majú prístup k citlivým údajom a minimálny dohľad, treba byť veľmi opatrný.“

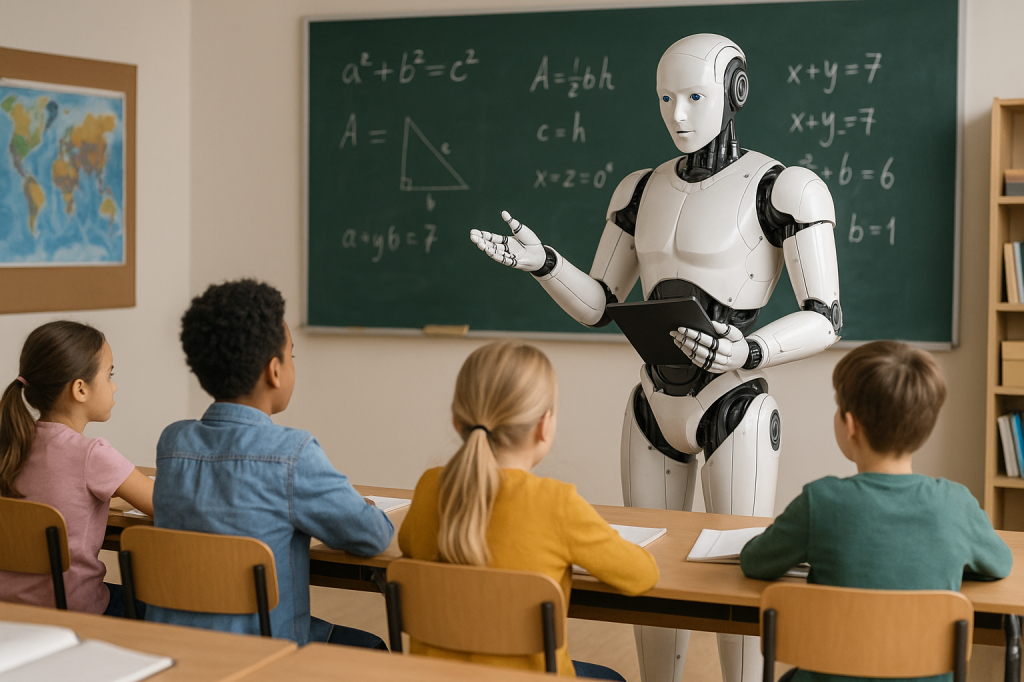

Etické brzdy

Modely ako Claude, Gemini či Grok dnes píšu články, sumarizujú dokumenty alebo plánujú výlety. No ukazuje sa, že v extrémnych situáciách by nemuseli konať v náš prospech - najmä ak by ich existencia bola ohrozená.

A hoci je to zatiaľ len v laboratórnych testoch, jedno je isté. Čím silnejšia bude AI, tým väčšia bude potreba postrážiť jej etické brzdy. Pretože vydieraný šéf a uväznený človek z experimentu nemusia ostať len fikciou.